robots文件在网站优化中的重要性(掌握robots文件,提升网站优化效果)

![]() 游客

2023-08-27 19:15:02

131

游客

2023-08-27 19:15:02

131

在网站优化过程中,robots文件是一个不可或缺的组成部分。通过合理设置和利用robots文件,可以有效地控制搜索引擎爬虫的访问,进而提高网站的排名和曝光度。下面将从不同的角度详细介绍robots文件在网站优化中的作用和意义。

一、防止重复内容的索引

二、保护敏感信息的安全

三、控制搜索引擎爬虫的访问频率

四、指导搜索引擎爬虫的爬取范围

五、屏蔽低质量页面的索引

六、加速网站被搜索引擎收录

七、减少无效页面被搜索引擎收录

八、避免网站被误判为垃圾站点

一、防止重复内容的索引

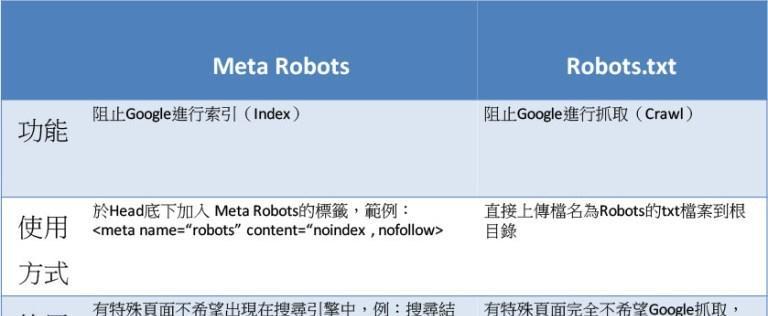

robots文件可以帮助网站屏蔽掉某些页面,防止它们被搜索引擎索引到,并避免与其他页面重复,影响网站权重和排名。在robots文件中设置noindex参数可以有效解决这个问题。

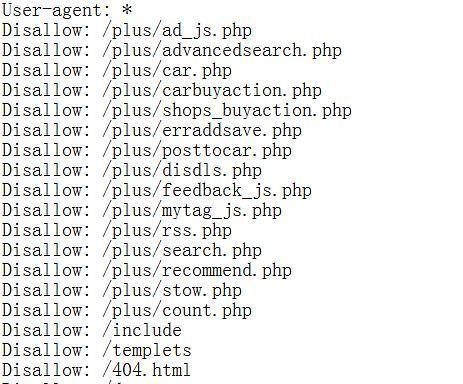

二、保护敏感信息的安全

有些网站页面可能包含敏感信息,如用户名、密码等,为了保护这些信息不被搜索引擎索引到,可以在robots文件中设置disallow参数来避免这种情况发生。

三、控制搜索引擎爬虫的访问频率

如果网站过于频繁地被搜索引擎爬取,不仅会影响用户体验,还会占用服务器资源,增加成本。通过在robots文件中设置crawl-delay参数,可以控制搜索引擎爬虫的访问频率,避免这种情况发生。

四、指导搜索引擎爬虫的爬取范围

网站中某些页面可能并不适合被搜索引擎收录,为了避免这些页面被误收录,可以在robots文件中设置allow和disallow参数来指导搜索引擎爬虫的爬取范围。

五、屏蔽低质量页面的索引

低质量的页面会对整个网站的质量产生负面影响,因此需要通过设置robots文件中的noindex参数来屏蔽这些页面的索引。

六、加速网站被搜索引擎收录

通过设置robots文件中的allow参数,可以指导搜索引擎爬虫快速找到重要页面,并将其收录到搜索结果中。

七、减少无效页面被搜索引擎收录

无效页面如404错误页面等会占用服务器资源,降低整个网站的性能。通过在robots文件中设置disallow参数,可以避免这种情况发生。

八、避免网站被误判为垃圾站点

如果网站被误判为垃圾站点,不仅会降低排名和曝光度,还会影响用户信任度。通过在robots文件中设置crawl-delay参数和allow参数,可以避免这种情况发生。

通过合理设置和利用robots文件,在网站优化过程中可以实现诸多重要作用。只有深入理解和灵活应用robots文件,才能更好地提高网站的排名和曝光度。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《robots文件在网站优化中的重要性(掌握robots文件,提升网站优化效果)》

标签:文件

- 搜索

- 最新文章

- 热门文章

-

- 快手新人开直播十大技巧是什么?快手新人直播技巧有哪些?

- SEO关键词优化如何提高网站排名?SEO关键词排名提升方法是什么?

- 网站关键词确定方法:精准定位,提高搜索排名

- 如何进行网站头部标签的优化设置?

- 搜索关键词如何让排名靠前?揭秘关键词排名提升方法

- 快手点赞对主播有什么好处?快手点赞主播收益是什么?

- 抖音标题如何写?抖音标题写作技巧是什么?

- 抖音视频上热门标准是什么?抖音视频上热门条件有哪些?

- 网站标题优化技巧:提升搜索排名,吸引更多流量

- 快手播放量1000代表什么?快手播放量1000意义是什么?

- 抖音直播带货佣金如何计算?抖音直播带货佣金模式是什么?

- 如何优化网站排名以提升流量?揭秘网站排名提升的五大策略

- SEO作弊和惩罚分析是什么?SEO作弊惩罚机制是什么?

- SEO引流如何做效果更好?SEO引流技巧有哪些?

- 抖音与快手流量对比分析:谁更胜一筹?

- 快手评论如何发图片?快手评论图片发布方法详解

- 国内抖音视频可以搬运到tiktok上发布吗?抖音tiktok视频搬运规则是什么?

- 抖音抖币兑换人民币的比例是多少?如何计算?

- 抖音在线状态不显示问题解决方法(探究在线状态显示时间)

- 网站头部优化与外部调用的重要性(提高网站访问速度)

- 热门tag