Robots文件在网站优化中的重要作用(了解Robots文件,提升网站SEO优化效果)

![]() 游客

2023-05-20 15:45:01

154

游客

2023-05-20 15:45:01

154

Robots文件是网站优化中重要的一环,它可以为搜索引擎提供网站内容、结构信息,帮助搜索引擎更好地理解网站,从而提升网站在搜索引擎中的排名。本文将详细介绍Robots文件在网站优化中的作用及其优化技巧。

一、Robots文件的定义

Robots文件,又称为爬虫协议或蜘蛛协议,是一个文本文件,位于网站根目录下,用于告诉搜索引擎哪些页面可以被搜索蜘蛛访问和抓取,哪些页面不可被抓取。

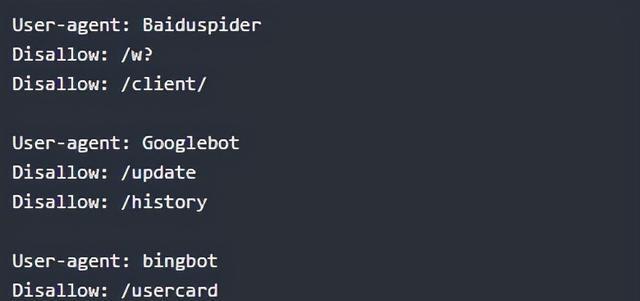

二、Robots文件的格式和语法

Robots文件的格式必须是文本格式,以robots.txt为文件名,放置在网站根目录下。语法包括User-agent、Disallow、Allow等指令。

三、Robots文件与搜索引擎之间的交互

Robots文件告诉搜索引擎哪些页面可以被搜索蜘蛛访问和抓取,哪些页面不可被抓取,但并不能保证搜索引擎一定会遵守这些指令。

四、Robots文件的作用

Robots文件可以控制搜索引擎对网站的抓取行为,使网站更易于被搜索引擎发现和收录,并可以控制搜索引擎对网站中的重要内容进行优先抓取。

五、Robots文件的优化技巧之允许和禁止访问

对于一些敏感信息和不想被搜索引擎收录的内容,可以使用Disallow指令,禁止搜索引擎访问和抓取。而允许搜索引擎访问和抓取的页面应该是网站中最重要、最有价值的页面。

六、Robots文件的优化技巧之指定Sitemap

Sitemap是一个XML文件,用于告诉搜索引擎网站中有哪些页面需要收录。通过在Robots文件中指定Sitemap地址,可以增加搜索引擎对网站的抓取效率和准确性。

七、Robots文件的优化技巧之设置Crawl-delay

对于一些大型网站,为了避免对服务器造成过大的负担,可以通过设置Crawl-delay指令,控制搜索引擎的抓取频率和速度。

八、Robots文件的优化技巧之处理重复内容

在Robots文件中设置Canonical指令,可以告诉搜索引擎哪些页面是主要内容页面,避免重复内容对搜索引擎排名的影响。

九、Robots文件的优化技巧之处理404页面

通过Robots文件中设置Custom 404页面,可以避免因为404页面的出现对搜索引擎排名造成的不利影响。

十、Robots文件的优化技巧之跟踪爬虫

在Robots文件中设置Log File指令,可以记录搜索引擎蜘蛛对网站的访问情况,方便分析和优化网站。

总结:Robots文件是网站优化中重要的一环,它可以为搜索引擎提供网站内容、结构信息,帮助搜索引擎更好地理解网站,从而提升网站在搜索引擎中的排名。通过掌握Robots文件的语法和优化技巧,可以有效地提高网站的SEO优化效果。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《Robots文件在网站优化中的重要作用(了解Robots文件,提升网站SEO优化效果) 》

标签:文件

- 上一篇: 抖音阶梯发货使用规范(规范您的店铺发货流程)

- 下一篇: 视频号认证有何不同(企业认证和个人认证详解)

- 搜索

- 最新文章

- 热门文章

-

- 网站制作中如何设计用户友好的界面?

- 小红书上搜索频率最高的关键词有哪些?

- unsplash素材网站如何使用?下载的图片版权问题如何处理?

- 小红书四个关键词入口怎么设置?提升笔记搜索可见性的方法是什么?

- 短视频关键词优化拍摄技巧是什么?如何吸引目标观众?

- 电脑b站屏蔽弹幕关键词的步骤是什么?

- 网站建设制作过程中常见的问题有哪些?

- 如何做矩阵账号抖音关键词优化?如何优化多个账号的关键词?

- 百度搜索引擎SEO优化有哪些技巧?效果如何?

- 抖音的关键词和标题怎么设置?

- 关键词搜索量怎么查?如何根据搜索量优化内容?

- 拼多多如何看关键词的搜索数据?查看关键词搜索数据的步骤是什么?

- 下拉关键词排名的优化技巧是什么?如何实现下拉关键词排名?

- seo培训网有哪些课程?如何选择适合自己的课程?

- 小红书如何通过关键词搜索帖子?

- 抖音通用关键词设置方法是什么?

- 关键词提取工具有哪些推荐?如何使用这些工具进行关键词提取?

- 关键词策略应该如何制定?如何利用关键词策略进行SEO优化?

- 淘宝关键词的优化作用有哪些?如何通过优化关键词提升店铺销量?

- 在拼多多购物时输入哪些关键词可以更便宜?

- 热门tag