网站robots文件怎么优化(seo网站页面优化包含)

![]() 三石哥

2023-01-29 09:39:02

148

三石哥

2023-01-29 09:39:02

148

错误的robots文件设置对SEO的影响

对于一个新站来说,搜索引擎爬虫来抓你的网站,他们就跟大爷一样,要好吃好喝的供着,你不能让别人自己端茶倒水,把别人累个半死,你说这样他回去会跟他主子(搜索引擎)说什么好话么?

那怎么让他们吃好喝好呢?其实也简单,就是让他们少做点,我们多做点,对于一个网站,那就是把目录结构尽量扁平话,但是要掌握好一个度,凡事过了就物极必反,蜘蛛来你网站,你肯定要想办法第一时间把最好的文章,最想排名的关键词让它带走,对于站长来说唯一能和蜘蛛交流的办法,就是robots.txt文件了,不知道这个东西?那可以看看这篇文章先《robots.txt文件介绍》

搜索引擎无用的网页

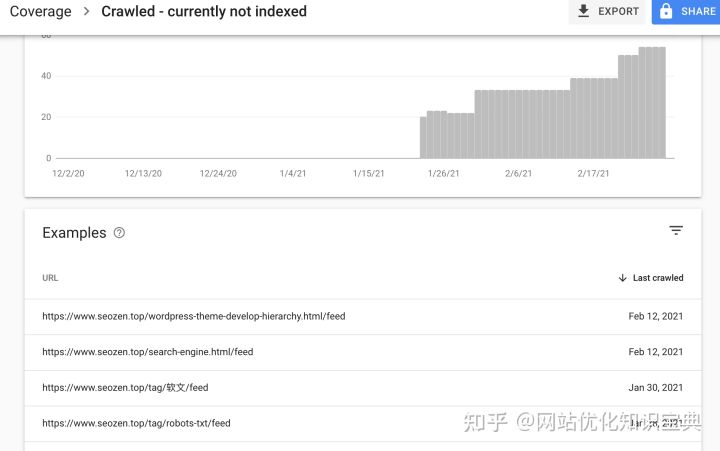

因为SEO小也这个站是使用WordPress搭建的,WordPress默认使用的是一个虚拟的robots.txt文件,内容比较简单,没有屏蔽feed页面,这个页面对搜索引擎来说没什么作用,谷歌也基本不收录

所以把这些文件排除,让搜索引擎蜘蛛只抓取那些对于他们有用的文件,因为蜘蛛来抓取一个网站是有时间限制的,如果把宝贵的时间花在这些没用的内容上,对网站优化来说就太浪费了。

错误的robots.txt规则

因为图省事,我就去网上找了一段robots.txt适用于WordPress的规则,当时也没多想,只直接写入到文件里面,但是没过两天,Google Search Console既然有错误提示?

说我移动设备兼容有问题?不可能啊,我前一段时间刚花了一天时间做了响应式布局的?难道我老了不中用了?响应式写错了?带着这么多疑问,我看了错误提示:

Googlebot blocked by robots.txt

原来我上次的骚操作,把wp-content内部的资源文件屏蔽了,下面是我修改以后完整的robots.txt文件内容,可以作为参考:

User-agent: *Disallow: /wp-admin/Disallow: /wp-content/Disallow: /wp-includes/Disallow: /*/comment-page-*Disallow: /*?replytocom=*Disallow: /category/*/page/Disallow: /tag/*/page/Disallow: /*/trackbackDisallow: /feedDisallow: /*/feedDisallow: /comments/feedDisallow: /?s=*Disallow: /*/?s=*\Disallow: /attachment/Allow:/wp-content/uploads/Allow:/wp-content/themes/seozen2021/Allow:/wp-content/plugins/Sitemap:https://www.seozen.top/sitemap.xml

上面这些规则简单的介绍下:

1、Disallow: /wp-admin/、Disallow: /wp-content/和Disallow: /wp-includes/

用于告诉搜索引擎不要抓取后台程序文件页面。

2、Disallow: /*/comment-page-*和Disallow: /*?replytocom=*

禁止搜索引擎抓取评论分页等相关链接。

3、Disallow: /category/*/page/和Disallow: /tag/*/page/

禁止搜索引擎抓取收录分类和标签的分页。

4、Disallow: /*/trackback

禁止搜索引擎抓取收录trackback等垃圾信息

5、Disallow: /feed、Disallow: /*/feed和Disallow: /comments/feed

禁止搜索引擎抓取收录feed链接,feed只用于订阅本站,与搜索引擎无关。

6、Disallow: /?s=*和Disallow: /*/?s=*\

禁止搜索引擎抓取站内搜索结果

7、Disallow: /attachment/

禁止搜索引擎抓取附件页面,比如毫无意义的图片附件页面。

8、Allow: /wp-content/uploads/

允许搜索引擎抓取资源文件,这个很重要,可以用来判断移动设备兼容性

因为这个操作,导致谷歌对SEO小也的收录不升还降了一点,我重新配置了robots.txt文件,观察一下过几天的情况再看看。

盘点网站SEO优化过程中常犯的技术错误

俗话说,得流量者得天下,SEO优化依然是当下企业主获取客户的主要方式,因为它可以把精准到客户引流到自己的企业,也是线上销售最精准的获客方式。但是随着搜索引擎的不断调整优化,SEO优化技术也在发生改变,想要真正做好SEO优化并不容易,因为许多的优化公司陷入了错误执行的SEO优化陷阱,最终也看不到好的流量和转化。本期内容慧运营网络为大家讲解网站SEO优化过程中常犯的技术错误!

一、禁止robots文件阻止搜索引擎访问网站

有时候站长在网站上线后由于粗心大意,会忘记设置robots协议,从而导致搜索引擎蜘蛛不能访问到网站,也就没有了后期的爬行抓取等操作。但是在某些情况下,如果网站页面的HTML代码中没有索引元标记,搜索引擎也有可能会显示你的网站,因为这种情况极有可能是因为网站内容与大量用户的搜索词相关性很高。

二、网站迁移需要做网站301重定向

网站在搬家的时候需要做301重定向,主要作用是能够保证链接流畅,如果没有做重定向,可能失去所有的访问者和所有链接。所以在做网站迁移的时候需要检查所有的链接有没有设置URL的重定向,可以通过访问服务器来实现这一点,要验证报告,需要下载Excel并使用VLOOKUP函数去验证URL。如果这个操作不懂,可以咨询慧运营网络优化导师,我们提供免费教学指导。

三、网站优化中尽量不使用循环重定向

如果网站页面有多个页面被重定向,可能就会发生循环重定向,也可能是服务器配置的问题。这个时候访问网站浏览器可能会返回:“错误310(net:ERR_TOO_MANY_REDIRECTS)”,也就是网站重定向过多的意思。

解决循环重定向的方法就是删除网站cookie,或者检测.htaccess文件,此文件清洁才能保证网站的安全,同时应该检查网站代码,清理不必要的重定向代码。

四、网站页面中合理设置404页面

搜索引擎程序会检测网站的错误页面,也就是404页面,404页面是为了保证用户体验,让用户在网站中访问到错误页面的时候不迷路,同时降低网站的跳出率,设置的404页面要确保可以自动返回到首页,如你需要给自己的网站设计404页面,可以联系慧运营网络,我们给你专业的建议和404源码程序。

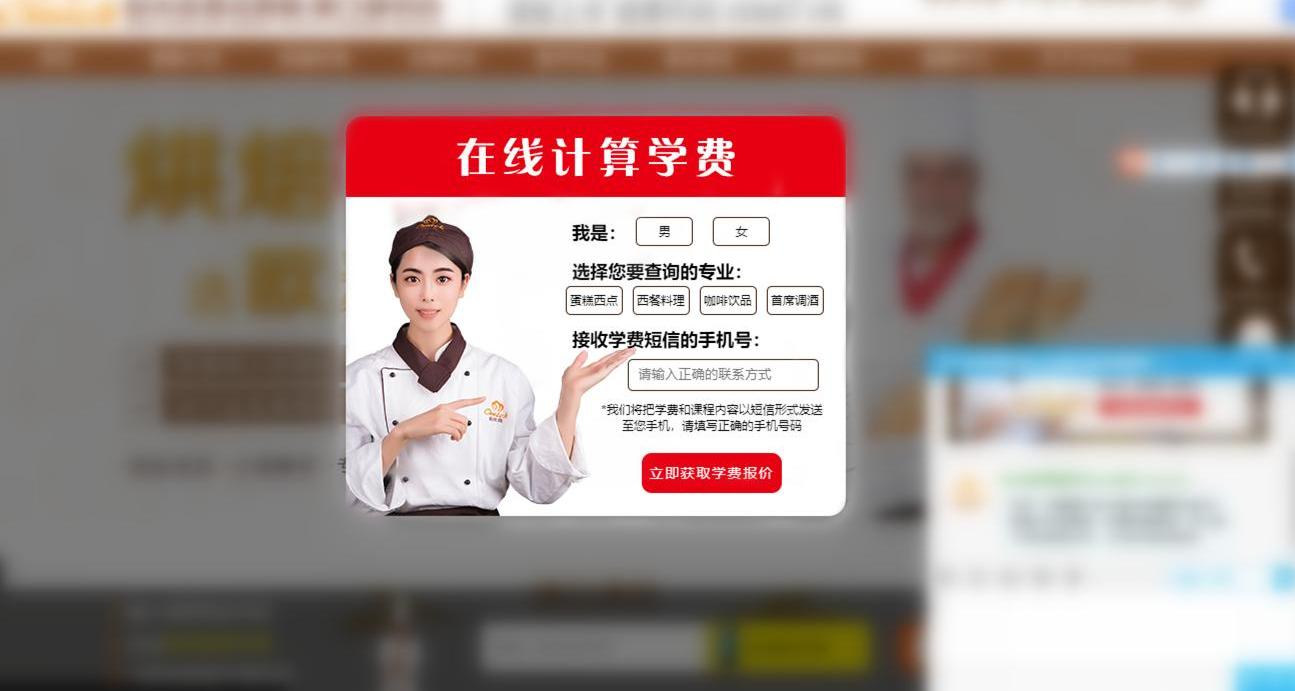

五、在线客服弹窗切记频繁弹出

很多人做优化网站有些流量之后都是急功近利,太注重客户咨询,所有在整个网站页面都设置了频繁的弹窗,从而大大增加了网站的跳出率,所以有此类问题的网站建议检查客服代码并查看弹出窗口的触发器,要记住一个原则;“少即是多”。

以上问题就是慧运营网络为大家讲解的SEO优化中经常遇到的一些技术错误,当然还有一些比较深层次的,我们会在后期的内容中做更新为大家讲解,如果你觉得本期的内容对你有用,欢迎你分享给更多的站长朋友;如果你对本期内容有其他好的见解,也欢迎你与我们沟通探讨,为大家输出更优质的SEO优化知识,我们下期见。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《网站robots文件怎么优化(seo网站页面优化包含)》

标签:seo网站优化

- 搜索

- 最新文章

- 热门文章

-

- 抖音代运营如何精准获客快速提升排名?

- 2025年有哪些网页设计趋势不容错过?

- 标题的seo的方法有哪些?如何优化标题提高搜索引擎排名?

- UI设计师必备技能有哪些?如何提升这些技能?

- 服务器连接失败原因揭秘?如何快速解决无法连接问题?

- 如何通过代运营提升店铺销量?

- 矩阵账号搭建从申请到内容分发的实操步骤是什么?

- ftp网站空间是什么?如何选择合适的ftp空间?

- 网站优化水平如何准确编写建议?有哪些技巧?

- uniapp前端框架是什么?它的特点和用途是什么?

- 什么是数字营销及其重要性?

- 如何打造属于自己的短视频App?

- aspnet如何实现连接层级?

- 零基础如何入门UI设计?

- 企业如何制定知识产权保护策略?保护策略集有哪些?

- 优秀网站设计的关键要素有哪些?

- 如何提高关键词排名?关键词排名有哪些关键因素?

- 企业建站需要多长时间才能完成?

- 如何保护Nodejs环境免受恶意软件攻击?

- 如何开发一个智慧社区内网平台的js+uniapp小程序?

- 热门tag