深入了解网站的robots文件(探索搜索引擎抓取网页的神秘机制)

![]() 游客

2025-02-21 11:15:01

55

游客

2025-02-21 11:15:01

55

随着互联网的发展,越来越多的人开始涉足网站开发和维护。而作为一名合格的网站管理员,了解和掌握robots文件的作用和使用方法是必不可少的。本文将深入探讨robots文件的含义、作用和使用技巧,帮助您更好地优化网站。

一:robots文件是什么

robots文件是一种存放在网站根目录下的文本文件,用于告诉搜索引擎哪些页面可以被爬取、哪些页面不可以被爬取。这个文件在访问一个网站时会自动被搜索引擎的蜘蛛程序查找并读取。一般来说,它的命名是"robots.txt"。

二:为什么需要robots文件

如果没有robots文件,搜索引擎的爬虫程序会自动地爬取所有的页面,这样不但浪费资源,而且可能导致网站被封禁。通过robots文件,管理员可以限制搜索引擎爬虫的访问范围,使得搜索引擎更好地抓取有价值的内容。

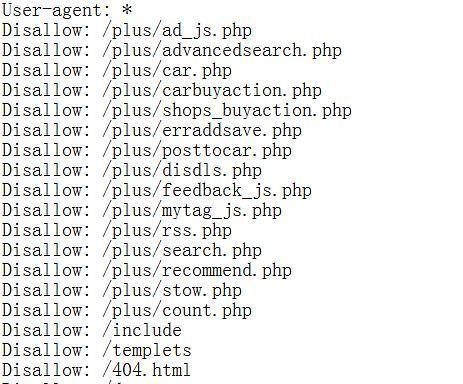

三:robots文件的语法规则

robots文件采用的是简单明了的语法规则,由若干行指令组成。每行指令由两个部分组成:User-agent和Disallow。其中User-agent指代搜索引擎蜘蛛程序的名称,而Disallow后面跟随着的则是被禁止访问的URL。

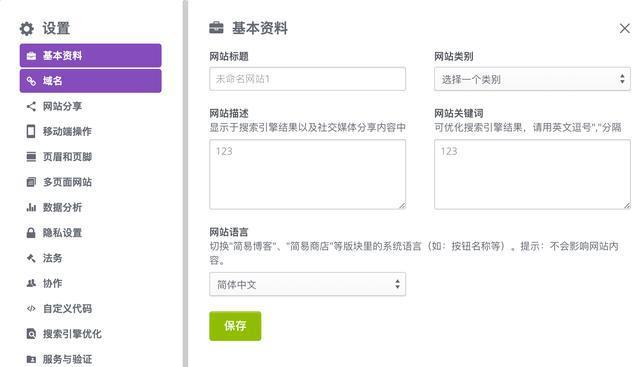

四:如何编写robots文件

编写robots文件并不是一件很困难的事情,只需要按照一定的语法规则进行编写即可。首先需要打开一个文本编辑器,然后依次添加User-agent和Disallow指令即可。最后将文件保存在网站根目录下即可。

五:robots文件对SEO的影响

一个好的robots文件可以对SEO产生积极的影响。通过控制搜索引擎蜘蛛程序访问网站的范围,可以使得搜索引擎更加关注网站中有价值的内容,从而提升网站排名和曝光度。

六:常见的robots文件使用错误

在编写和使用robots文件时,很容易出现一些常见的错误。将Disallow设置为"/"就意味着禁止搜索引擎抓取整个网站,这是非常不可取的。还有一些管理员会误认为"User-agent:*"就表示允许所有搜索引擎爬取,这也是错误的。

七:如何验证robots文件是否正确

为了验证自己编写的robots文件是否正确,我们可以通过GoogleSearchConsole等工具进行验证。这些工具可以帮助我们发现我们可能存在的错误,并给出相应的修改建议。

八:

在今天这个信息化时代,拥有一个良好的网站对于企业和个人来说至关重要。通过学习和了解robots文件的作用和使用方法,可以帮助我们更好地管理和优化我们的网站,提升用户体验和SEO排名。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《深入了解网站的robots文件(探索搜索引擎抓取网页的神秘机制)》

标签:文件

- 搜索

- 最新文章

- 热门文章

-

- 抖音代运营如何精准获客快速提升排名?

- 2025年有哪些网页设计趋势不容错过?

- 标题的seo的方法有哪些?如何优化标题提高搜索引擎排名?

- 服务器连接失败原因揭秘?如何快速解决无法连接问题?

- 如何通过代运营提升店铺销量?

- 矩阵账号搭建从申请到内容分发的实操步骤是什么?

- 网站优化水平如何准确编写建议?有哪些技巧?

- uniapp前端框架是什么?它的特点和用途是什么?

- 零基础如何入门UI设计?

- 企业如何制定知识产权保护策略?保护策略集有哪些?

- 什么是数字营销及其重要性?

- 如何提高关键词排名?关键词排名有哪些关键因素?

- 快手号个性化标题与内容如何锁定不变?

- 2025年有哪些网站设计制作推荐?

- 简书营销号如何开通并实现引流?

- 社会化媒体营销的策略与方法有哪些?

- 响应式布局为何是网页设计的关键?如何实现多设备适配?

- 哪些策略可以增强我的博客网站SEO优化和用户满意度?

- 如何平衡SEO与PPC策略以提升在线可见性?

- 小红书营销必学方法有哪些?

- 热门tag