深入探究网站优化中的robotstxt文件(原理)

![]() 游客

2024-11-13 11:30:01

69

游客

2024-11-13 11:30:01

69

在进行网站优化的过程中,我们需要借助robotstxt文件来控制爬虫的抓取行为。但是,如果设置不当,就有可能会对网站的排名产生负面影响。深入了解robotstxt文件的原理、设置和注意事项是非常有必要的。

一、什么是robotstxt文件

robotstxt文件是一种位于网站根目录下的文本文件,用于告诉搜索引擎蜘蛛哪些页面可以被访问,哪些页面不允许被访问。它相当于一个“交通指示牌”,可以控制搜索引擎蜘蛛的抓取行为。

二、robotstxt文件的作用原理

robotstxt文件的作用原理非常简单,就是通过限制蜘蛛抓取的路径来达到控制抓取行为的目的。当搜索引擎蜘蛛访问一个网站时,它首先会读取该网站下的robotstxt文件,然后根据文件中的规则来决定是否抓取该页面。

三、robotstxt文件的格式和语法

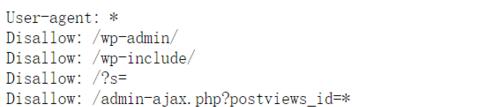

robotstxt文件的格式和语法非常简单,它由一系列的User-agent和Disallow组成。User-agent指定了搜索引擎蜘蛛的名称或类型,而Disallow则指定了该蜘蛛不能访问的页面路径。

四、设置robotstxt文件的注意事项

在设置robotstxt文件时,需要注意以下几个方面:1、确保robotstxt文件存在于网站的根目录下;2、遵循规范的语法格式;3、不要阻止搜索引擎抓取重要的页面;4、注意避免出现错误的语法或拼写错误。

五、如何检查robotstxt文件

为了确保robotstxt文件设置正确,我们可以通过一些工具来进行检查。可以使用GoogleSearchConsole中的robots.txtTester工具来验证文件是否能被正确解析。

六、robotstxt文件的常见误区

在设置robotstxt文件时,有一些常见的误区需要避免。一些站长可能会将所有页面都设置为Disallow,这样就会导致整个网站都不能被搜索引擎收录。有些站长还可能会在Disallow后面加上“*”,这样就会将所有页面都屏蔽。

七、如何设置多个User-agent

在设置robotstxt文件时,我们可能需要对不同类型的搜索引擎蜘蛛设置不同的规则。这时候,我们可以通过多个User-agent来实现。可以设置User-agent为Googlebot和Baiduspider,然后对它们分别设置不同的规则。

八、如何禁止搜索引擎访问某个文件或文件夹

如果我们想要禁止搜索引擎访问某个文件或文件夹,可以将该文件或文件夹的路径添加到Disallow中。可以将Disallow设置为“/cgi-bin/”来禁止搜索引擎访问该目录下的所有文件。

九、如何允许搜索引擎访问某个文件或文件夹

如果我们想要允许搜索引擎访问某个文件或文件夹,可以将该文件或文件夹的路径添加到Allow中。需要注意的是,Allow并不是robotstxt标准语法,所以并不是所有的搜索引擎都支持。

十、如何设置Sitemap路径

我们可以在robotstxt文件中添加Sitemap路径,告诉搜索引擎网站地图的位置。可以将Sitemap设置为“Sitemap:https://www.example.com/sitemap.xml”。

十一、robotstxt文件对网站排名的影响

虽然robotstxt文件并不能直接影响网站的排名,但是它可以控制搜索引擎蜘蛛抓取的页面,从而间接影响网站的收录和排名。

十二、robotstxt文件与robotsmeta标签的关系

robotstxt文件和robotsmeta标签都是用于控制搜索引擎蜘蛛的抓取行为的,但是二者的作用范围和作用方式不同。robotsmeta标签通常用于单个页面的控制,而robotstxt文件用于整个网站的控制。

十三、robotstxt文件常见错误解决方法

在设置robotstxt文件时,可能会出现一些常见的错误,例如Disallow拼写错误、User-agent设置错误等。如果出现这些错误,我们可以通过排查语法错误或查看搜索引擎日志来解决。

十四、如何优化robotstxt文件

为了更好地优化robotstxt文件,我们可以通过以下几个方面来实现:1、删除无用的规则;2、减少规则条数;3、避免对重要页面进行阻止;4、设置Sitemap路径。

十五、

通过本文的介绍,相信大家已经对robotstxt文件的原理、格式、设置和注意事项有了更深入的了解。在进行网站优化时,合理设置robotstxt文件是非常重要的一步,希望大家能够从中受益并应用于实践中。

深入了解网站优化robotstxt的原理与设置

为了提高网站的SEO效果,网站管理员需要使用各种手段对网站进行优化,其中之一就是通过设置robotstxt文件来控制搜索引擎爬虫的访问权限。本文将深入探讨robotstxt的作用及设置方法,帮助网站管理员了解这一重要优化技术。

一、什么是robotstxt文件

在了解robotstxt文件的作用及设置方法前,首先需要了解robotstxt文件的概念。robotstxt文件是一个文本文件,位于网站的根目录下,它用来指导搜索引擎爬虫访问网站的哪些页面,哪些页面不允许爬虫访问。实际上,它是一个“防火墙”,可以帮助网站管理员控制搜索引擎爬虫的行为,以达到更好的SEO效果。

二、robotstxt文件的作用

robotstxt文件主要有以下两个作用:

1.控制搜索引擎爬虫访问权限

通过在robotstxt文件中设置相关规则,网站管理员可以控制搜索引擎爬虫访问网站的哪些页面,哪些页面不允许爬虫访问,从而有效地控制网站的流量。

2.提高网站的SEO效果

通过设置robotstxt文件,网站管理员可以将搜索引擎爬虫引导到重要的页面上,从而提高这些页面的权重和排名。同时,也可以阻止搜索引擎爬虫访问一些无关紧要的页面,避免浪费爬虫资源,提高搜索引擎爬虫的访问效率。

三、robotstxt文件的语法格式

robotstxt文件的语法格式比较简单,主要由以下两个部分组成:

1.User-agent

User-agent是指搜索引擎爬虫的名称,也可以使用通配符“*”表示所有搜索引擎爬虫。例如:

User-agent:*

2.Disallow

Disallow是指不允许搜索引擎爬虫访问的页面或目录。例如:

Disallow:/admin/

四、robotstxt文件设置的注意事项

在设置robotstxt文件时,需要注意以下几点:

1.不要将robotstxt文件放在错误的位置

robotstxt文件必须放在网站的根目录下,否则会被搜索引擎爬虫忽略。

2.不要将重要页面放在Disallow列表中

如果将重要页面放在Disallow列表中,则搜索引擎爬虫无法访问这些页面,从而会影响网站的SEO效果。必须谨慎地设置Disallow列表。

3.不要将robotstxt文件设置为可写

如果将robotstxt文件设置为可写,任何人都可以修改该文件,从而可能导致搜索引擎爬虫无法正确地访问网站。

五、robotstxt文件设置的实例

下面是一个robotstxt文件的实例:

User-agent:*

Disallow:/admin/

Disallow:/tmp/

Disallow:/test/

Disallow:/cgi-bin/

Disallow:/images/

Disallow:/docs/

Disallow:/backup/

Disallow:/log/

Disallow:/uploads/

Disallow:/cache/

Disallow:/include/

Disallow:/scripts/

Disallow:/fonts/

Disallow:/data/

Disallow:/vendor/

Disallow:/node_modules/

Disallow:/*.php$

Allow:/

以上实例中,我们使用User-agent设置了所有搜索引擎爬虫的访问规则,并在Disallow列表中设置了一些不允许访问的页面或目录。同时,在Allow列表中设置了允许访问的页面或目录。

六、robotstxt文件的常见错误

在设置robotstxt文件时,可能会出现一些常见的错误,例如:

1.将robotstxt文件放置在错误的位置。

2.设置错误的语法格式。

3.将重要页面放在Disallow列表中。

4.将robotstxt文件设置为可写。

5.设置过于严格的规则,导致搜索引擎爬虫无法访问重要页面。

七、robotstxt文件在SEO优化中的应用

在SEO优化中,robotstxt文件是一个重要的优化技术。通过合理设置robotstxt文件,可以控制搜索引擎爬虫的访问权限,从而提高网站的SEO效果。同时,在设置robotstxt文件时,需要考虑到以下几点:

1.不要将重要页面放在Disallow列表中。

2.不要将robotstxt文件设置为可写。

3.不要设置过于严格的规则,导致搜索引擎爬虫无法访问重要页面。

4.必须定期检查并更新robotstxt文件,以适应网站的变化。

八、如何检测robotstxt文件是否设置正确

在设置完robotstxt文件后,需要及时检测是否设置正确。通常有以下几种方法:

1.使用GoogleSearchConsole来检测是否设置正确。

2.在浏览器中直接访问robotstxt文件并检查是否包含正确的语法格式和规则。

3.使用在线工具进行检测。

九、robotstxt文件与sitemap.xml的区别

在SEO优化中,除了robotstxt文件外,还有一个重要的文件是sitemap.xml。与robotstxt不同的是,sitemap.xml是用来告诉搜索引擎爬虫网站的结构和页面的重要性,从而帮助搜索引擎更好地了解网站的内容和结构。sitemap.xml与robotstxt是不同的两个文件,它们分别用于控制搜索引擎爬虫的访问权限和告诉搜索引擎网站的结构和页面。

十、robotstxt文件的优化策略

在优化robotstxt文件时,需要考虑以下几个方面:

1.根据网站的实际情况,合理设置Disallow规则。

2.不要将重要页面放在Disallow列表中。

3.将一些不必要的页面或目录放在Disallow列表中,避免浪费搜索引擎爬虫的资源。

4.定期检查并更新robotstxt文件,以适应网站的变化。

5.在设置Disallow规则时,尽量使用目录而不是文件名。

八、robotstxt文件的最佳实践

在使用robotstxt文件时,需要遵循以下几个最佳实践:

1.不要阻止搜索引擎爬虫访问重要页面。

2.不要将robotstxt文件设置为可写。

3.定期检查并更新robotstxt文件,以适应网站的变化。

4.在设置Disallow规则时,尽量使用目录而不是文件名。

5.及时移除不必要的Disallow规则。

6.避免使用通配符“*”来控制搜索引擎爬虫的访问权限。

九、

robotstxt文件是一个重要的SEO优化技术,可以帮助网站管理员控制搜索引擎爬虫的访问权限,从而提高网站的SEO效果。在设置robotstxt文件时,需要遵循一些注意事项和最佳实践,避免出现常见错误。同时,也需要定期检查并更新robotstxt文件,以适应网站的变化。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《深入探究网站优化中的robotstxt文件(原理)》

标签:北京SEO

- 搜索

- 最新文章

- 热门文章

-

- 免费ppt模板下载网站有哪些?如何选择合适的ppt模板?

- 长尾关键词怎么优化?有效策略和步骤是什么?

- 站长工具、怎么使用?如何优化网站SEO?

- 网页设计制作网站如何选择?有哪些设计趋势?

- 素材网站如何选择才能满足SEO需求?

- 常用的搜索引擎有哪些?它们各自的特点是什么?

- 遇到拼多多关键词推广无权限该如何处理?

- 抖音标题关键词应该怎么设置?

- 搜索引擎的工作原理是什么?它是如何运作的?

- SEO快速排名优化技巧?如何在短时间内提升网站排名?

- 优化网站关键词排名的策略有哪些?SEO优化系统如何帮助提升排名?

- 网站设计对SEO有多重要?如何优化网站设计以提高搜索引擎排名?

- seo关键词的选择技巧是什么?

- 抖音关键词抽帧功能如何使用?

- 热门关键词如何选择?如何进行有效的关键词优化?

- 搜索引擎的工作原理是什么?如何优化?

- 站长工具、中的关键词密度分析如何进行?

- 淘宝关键词在手机上搜不到的解决方法?

- 临邑网站建设的常见问题有哪些?

- 免费ppt模板下载网站有哪些推荐?如何快速找到合适的模板?

- 热门tag