如何处理网站中大量重复内容(有效解决网站SEO优化问题)

![]() 游客

2023-11-07 09:15:03

232

游客

2023-11-07 09:15:03

232

在进行SEO优化过程中,遇到网站中大量重复内容的情况时,不仅会影响网站的排名,还会降低用户体验。本文将为大家介绍如何有效解决网站中大量重复内容的问题。

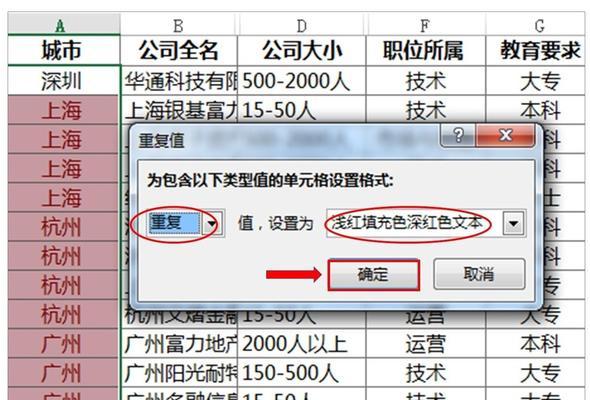

一:了解网站中的重复内容

重复内容可能出现在网站的不同页面、相似页面和产品描述中。了解网站中出现的重复内容,并清理掉这些不必要的内容是解决问题的第一步。

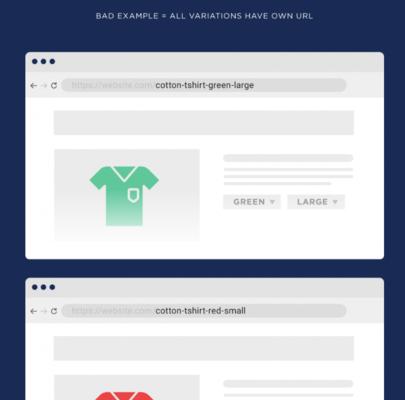

二:使用301重定向

当网站存在相似的页面或重复的URL时,可以使用301重定向,将这些页面指向主要页面,从而避免搜索引擎将这些页面视为独立页面。

三:使用canonical标签

使用canonical标签可以告诉搜索引擎哪个页面是主要页面。这样搜索引擎就会忽略其他相似的页面,而只将主要页面视为独立页面。

四:优化产品描述

如果网站存在大量重复的产品描述,可以通过优化这些描述来避免搜索引擎将这些页面视为重复内容。可以使用不同的标题、描述和关键字来区分不同的产品描述。

五:重新编写相似页面

如果网站存在相似的页面,可以重新编写这些页面,使它们与其他页面有所区别。可以使用不同的标题、描述和关键字,或者添加新的图片和视频来使页面更加丰富。

六:使用Robots.txt文件

Robots.txt文件是一个文本文件,用于向搜索引擎指示哪些页面需要被抓取,哪些页面不需要被抓取。可以使用Robots.txt文件来防止搜索引擎抓取相似的页面或不必要的页面。

七:增加内部链接

增加内部链接可以帮助搜索引擎更好地理解网站的结构和内容。通过在不同的页面之间添加内部链接,可以帮助搜索引擎发现主要页面,并将其他相似页面忽略掉。

八:增加外部链接

增加外部链接可以提高网站的权威性和可信度。搜索引擎会将外部链接作为对网站权威性的评价标准。通过增加外部链接可以帮助搜索引擎更好地理解网站的内容。

九:定期检查和清理

为了保持网站的优化效果,需要定期检查和清理网站中的重复内容。通过定期检查和清理可以及时发现并解决问题,避免问题再次出现。

十:

本文为大家介绍了如何有效解决网站中大量重复内容的问题。通过了解网站中的重复内容、使用301重定向、使用canonical标签、优化产品描述、重新编写相似页面、使用Robots.txt文件、增加内部链接、增加外部链接、定期检查和清理等措施,可以有效地提升网站的SEO优化效果。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《如何处理网站中大量重复内容(有效解决网站SEO优化问题)》

标签:重复内容

- 搜索

- 最新文章

- 热门文章

-

- 抖音代运营如何精准获客快速提升排名?

- 谷歌云Next大会对软件板块和ETF(5152)的影响是什么?

- 网站Title标题优化技巧有哪些?优化时应注意哪些事项?

- 标题的seo的方法有哪些?如何优化标题提高搜索引擎排名?

- UI设计师必备技能有哪些?如何提升这些技能?

- 如何实现银发经济自媒体运营的精准引爆?

- 2025年有哪些网页设计趋势不容错过?

- 服务器连接失败原因揭秘?如何快速解决无法连接问题?

- 矩阵账号搭建从申请到内容分发的实操步骤是什么?

- 如何通过代运营提升店铺销量?

- ftp网站空间是什么?如何选择合适的ftp空间?

- 网站优化水平如何准确编写建议?有哪些技巧?

- 网站的死链接有什么影响?如何检测和修复死链接?

- 什么是数字营销及其重要性?

- uniapp前端框架是什么?它的特点和用途是什么?

- 企业如何制定知识产权保护策略?保护策略集有哪些?

- 零基础如何入门UI设计?

- 如何打造属于自己的短视频App?

- 优秀网站设计的关键要素有哪些?

- aspnet如何实现连接层级?

- 热门tag